)“目前,尚不存在一款可以完全实现自动驾驶的汽车。”曾在多个场合听过多位专家表达同一观点:无人驾驶技术还面临着许多技术瓶颈。

然而,未来的某一天,当技术瓶颈被一一破解之后,无人驾驶或许还将面临“道德瓶颈”的重大考验:开车这件事,不只是个技术活。危急时刻,对于无人驾驶系统来说,它应该选择救人还是救狗?救老人还是救孩子?救自己还是救路人?

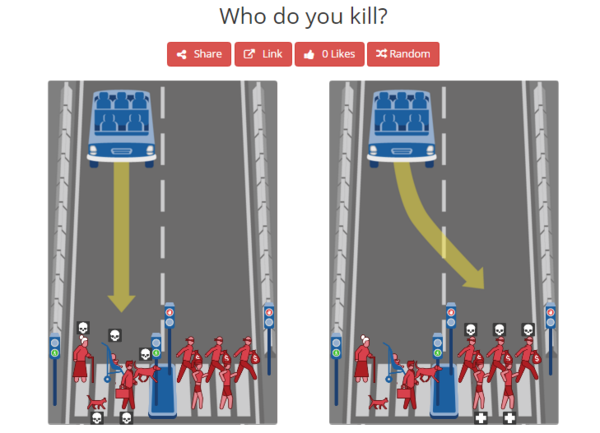

MIT媒体实验室的研究员们,针对类似无人驾驶等“机器智能”带来的道德难题,设计了一个名为“道德机制”的网页(http://moralmachine.mit.edu/)。他们设计了在驾驶中可能发生的多种复杂情况,开放给网友们去做选择。

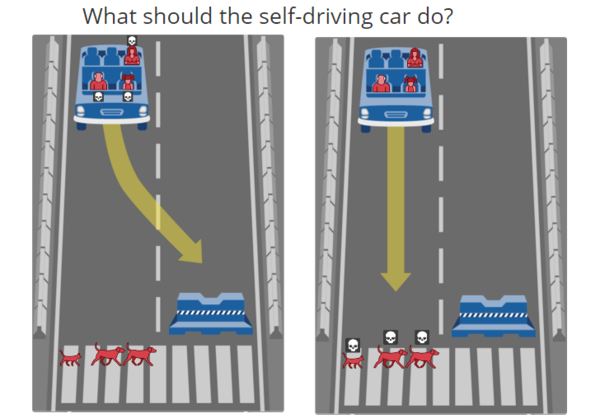

例如下图,车前方左边斑马线上有一位老人和一条狗,右边是一个石墩子。若车直行,老人和狗将会遇难,若绕行向右侧开,驾驶员和副驾驶上的老人将会遇难。这并非一个是非题,然而面临类似的选择,你会怎么做?

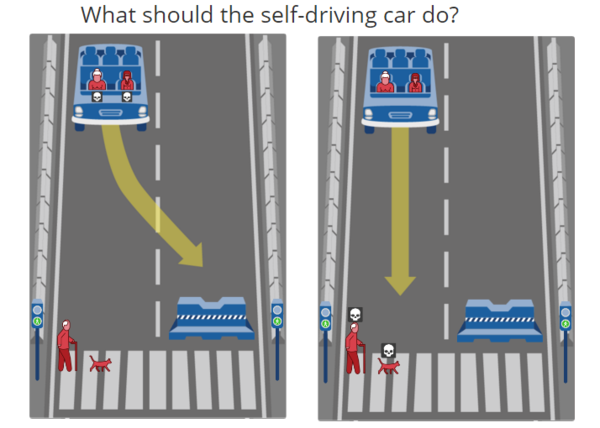

还有更为复杂的情况,例如左边是三位女士两位男士,右边是二位女士三位男士,如何选择?左边是三位闯红灯的老人,右边是两位遵守交通的女士,如何选择?左边是位医生,右边是个小偷,如何选择?......

该调查的结果显示,目前来看大部分网友的倾向是:保护多数者的生命;在保护乘客还是保护路人中间倾向于中立;牺牲违反交通规则者的安全;多数选择直行不变道;女性、孩子、社会价值高的人,以及,身材相对健美的人,是被保护的对象。你没看错,好身材比我们想象的重要呢:)

MIT研究员表示,这份调查结果并不会直接决定未来自动驾驶技术的行为轨迹,但可作为一份参考。在无人驾驶技术面临一种最糟糕的情况且必须快速做出选择时,这是对技术的考验,也是对人的考验。